身为目前最强的AI加速运算单元,Blackwell GPU不但具有强悍的性能,还可通过串联多组GPU方式构建“超大型GPU”,带来更高的总体性能与吞吐量。

NVIDIA推出了多种Blackwell GPU组态,包含集成8组GPU的HGX形式超级计算机,以及集成2组GPU搭配1组Grace CPU的GB200运算节点,而它们又可以彼此串联成为更大型的运算集群。

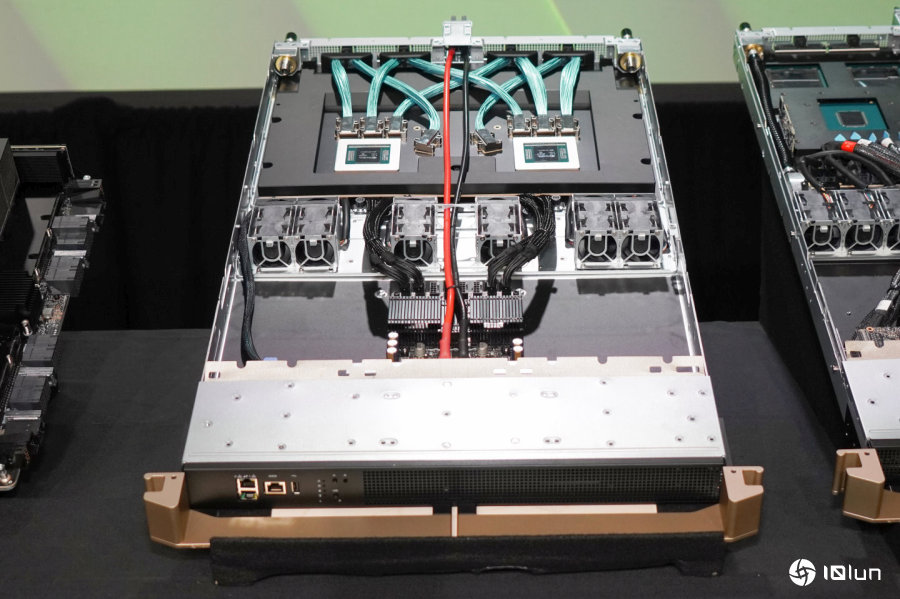

NVIDIA在GTC大会上主要推广的型号为集成2组Blackwell GPU与1组Grace CPU的GB200 Superchip,NVIDIA推出的GB200 Superchip运算节点(Compute Node)则是将2组GB200 Superchip安置于1U高度的服务器,并采用水冷散热方案,能让单组GB200 Superchip的TDP达到2700W,完全解放性能表现。

此外NVIDIA也会推出采用SXG界面的B200与B100等GPU,且都能够以8组GPU组成HGX B200或HGX B100服务器,2者主要的差异在于B200的TDP最高可达1000W,而B100仅为800W。

NVIDIA超大规模与高性能计算副总裁暨宏观经济理Ian Buck也在媒体访谈中补充说明,若将B200安置于服务器并搭配水冷散热方案,则可将TDP上调至1200W,进一步提高运算性能。

另一方面,在散热与供电许可的范围下,B200与B100 GPU能够直接与现有H100 HGX或兼容服务器进行GPU替换(Drop-in Replace),提供更大的升级弹性并节省升级费用。

(若下方表格无法完整显示,请点击我看图片版)

(若下方表格无法完整显示,请点击我看图片版)

Blackwell GPU的实体图片,更多详细介绍可看笔者的前篇报道。

Blackwell GPU的实体图片,更多详细介绍可看笔者的前篇报道。

GB200 Superchip集成2组Blackwell GPU与1组Grace CPU。

GB200 Superchip集成2组Blackwell GPU与1组Grace CPU。

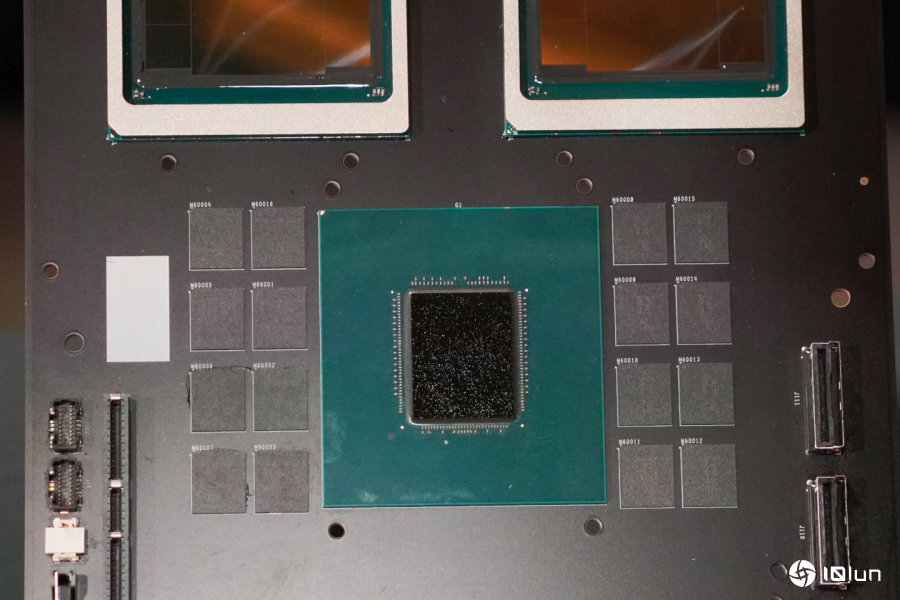

GB200 Superchip的实体图片,上方为2组Blackwell GPU,中央则为Grace CPU与LPDDR5x内存。

GB200 Superchip的实体图片,上方为2组Blackwell GPU,中央则为Grace CPU与LPDDR5x内存。

每组Blackwell GPU内置容量为384 GB的HBM3e高带宽内存。

每组Blackwell GPU内置容量为384 GB的HBM3e高带宽内存。

Grace CPU则在外部配置最大480 GB LPDDR5X内存。

Grace CPU则在外部配置最大480 GB LPDDR5X内存。

GB200 Superchip运算节点集成2组GB200 Superchip,搭配水冷散热方案,安置于1U高度的服务器。(左方为去除水冷头的情况)

GB200 Superchip运算节点集成2组GB200 Superchip,搭配水冷散热方案,安置于1U高度的服务器。(左方为去除水冷头的情况)

此外客户也可以选则集成8组SXG界面Blackwell GPU的HGX B200或HGX B100服务器。

此外客户也可以选则集成8组SXG界面Blackwell GPU的HGX B200或HGX B100服务器。

Blackwell GPU的另一大创新功能,就是能够通过NVLink串联最多576组Blackwell GPU,让整个集群犹如组成单一超大GPU,达到扩大运算性能、共享内存、执行规模更大模型的能力。

而NVIDIA也推出了GB200 NVL72服务器,它的机柜(Rack)具有18组GB200 Superchip运算节点以及9组NVLink交换机(每组交换机具有2组NVLink交换机芯片所),能在由72组GPU组成的NVL72域名集群中,以130 TB/s的带宽交换数据。而跨多台机柜的GPU数据则会通过InfiniBand网络传输。

相对于Blackwell GPU芯片内部的2组裸晶通过带宽高达10 TB/s的NV-HBI(NVIDIA High-Bandwidth Interface)芯片对芯片互联(Chip-to-Chip Interconnection)相连,多颗GPU之间则是通过第5代NVLink相连。它采用18信道(Link)的高速差分信号对(High-Speed Differential Pair),能够提供总共高达1.8 TB/s的双向带宽(即单向为900 GB/s),最高能支持576组GPU相连,远高于前代的256组GPU。

第5代NVLink的频远远高出PCIe Gen 5x16的14倍,其1小时的双向传输量综合约为6.32 PB,大约等同于18年4K电影流媒体的数据量,或是11组Blackwell GPU之间的传数量综合就与整个网际网络相当,对于执行大型AI模型的性能表现扮演重要角色。

(若下方表格无法完整显示,请点击我看图片版)

NVLink交换机芯片能够串联最多576组Blackwell GPU组成单一超大GPU,达到扩大运算性能、共享内存、执行规模更大模型的能力。

NVLink交换机芯片能够串联最多576组Blackwell GPU组成单一超大GPU,达到扩大运算性能、共享内存、执行规模更大模型的能力。

NVLink交换机由2组NVLink交换机芯片构成,并提供144组NVLink端子,无阻塞交换刘量答14.4 TB/s,为GB200 NVL72系统提供高带宽和低延迟数据交换能力。

NVLink交换机由2组NVLink交换机芯片构成,并提供144组NVLink端子,无阻塞交换刘量答14.4 TB/s,为GB200 NVL72系统提供高带宽和低延迟数据交换能力。

GB200 NVL72机柜具有18组GB200 Superchip运算节点,总共包含72组Blackwell GPU与36组Grace CPU。

GB200 NVL72机柜具有18组GB200 Superchip运算节点,总共包含72组Blackwell GPU与36组Grace CPU。

GB200 NVL72机柜背面则有称为NVLink Spine(NVLink脊椎)的数据连接缆线,GPU串联在一起。

GB200 NVL72机柜背面则有称为NVLink Spine(NVLink脊椎)的数据连接缆线,GPU串联在一起。

NVIDIA不但通过CUDA确立了AI运算软件与框架的领先优势,随着Blackwell架构推出的第5代NVLink也支持串联更多GPU,进而提供更庞大的运算能力以及内存总容量,让竞争对手望尘莫及。