https://github.com/MenghaoGuo/Awesome-Vision-Attentions

论文链接: https://arxiv.org/abs/2111.07624 注意力机制相关论文: https://github.com/MenghaoGuo/Awesome-Vision-Attentions

一、研究背景

人类视觉系统可以自然高效地找到复杂场景中的重要的区域,受到这种现象的启发,注意力机制(Attention Mechanisms)被引入到计算机视觉系统中。注意力机制已经在计算机视觉的各种任务(如:图像识别、目标检测、语义分割、动作识别、图像生成、三维视觉等)中取得了巨大的成功。

但是,研究人员在研究不同任务的注意力机制的时候,往往注重的是任务本身,而忽略了注意力机制本身就是一个研究方向,是一个尝试用计算机视觉系统模拟人类视觉系统的研究方向。

该综述尝试从两个角度将视觉中不同任务中的注意力机制连接成一个整体——从注意力机制本身出发,对整个领域进行了系统地总结归纳,并给出了未来潜在的研究方向。

二、什么是注意力机制

其中

对于 senet 来说,可以将上述公式具体化为:

接下来,该综述尝试将不同的注意力机制进行具体化,即明确

三、视觉中注意力机制的发展过程

视觉中注意力机制的发展过程如图1所示。

图1 视觉中注意力机制的发展过程

视觉中的注意力机制可以粗略的分成四个部分:

· 第一个部分是开始于 RAM[4],特点是都使用了RNN网络进行产生注意力。

· 第二个部分是开始于 STN[5],特点是显式地预测重要的区域,代表性工作还有DCNs[6, 7] 等。

· 第三个部分是开始于 SENet[3],特点是隐式地预测重要的部分,代表性工作还有CBAM[8] 等。

·第四个部分是自注意力机制相关的注意力方法,代表性工作有Non-Local[2], ViT[9] 等。

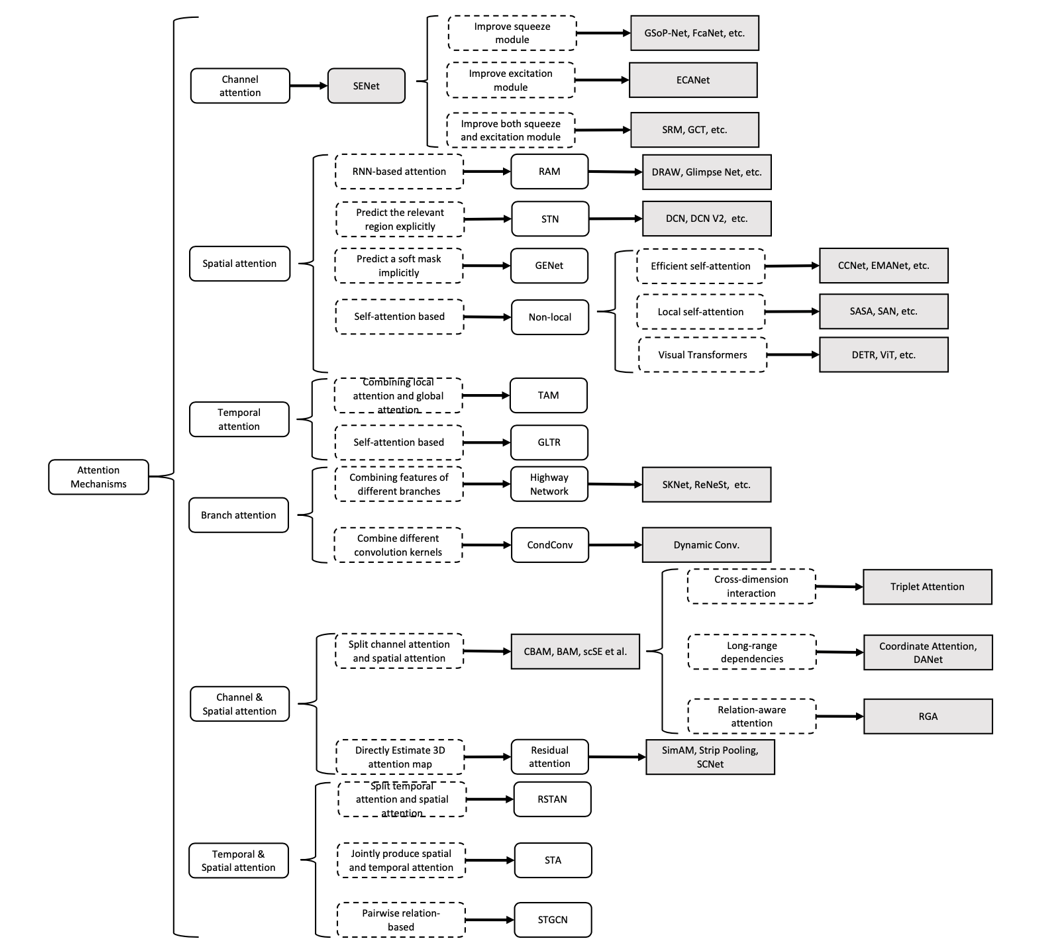

图2给出了这些方法的分类树。

图2 视觉中注意力机制的发展过程

图2 视觉中注意力机制的发展过程

作者根据注意力方法本身对视觉中不同的注意力机制进行了分类,而不是根据不同的应用,从而对注意力机制的研究给了一个统一的视角。

如图三所示,作者根据注意力作用的不同维度将注意力分成了四种基本类型:通道注意力、空间注意力、时间注意力和分支注意力,以及两种组合注意力:通道-空间注意力和空间-时间注意力。

图3 将视觉中注意力机制的分类示意图

图4进一步给出图3中注意力的具体解释。

图4 注意力机制的分类的可视化展示

不难发现,对于不同的注意力机制,他们有着不同的含义,比如对于通道注意力,它关注于选择重要的通道,而在深度特征图中,不同的通道往往表示不同的物体,所以它的含义是关注什么(物体),即what to attend。

同理,空间注意力对应 where to attend, 时间注意力对应 when to attend,分支注意力对应 which to attend。具体的注意力机制请参见论文。

该综述文还提出了注意力机制方面七个潜在的研究方向,分别为:

1. 注意力机制的充分必要条件

2. 更加通用的注意力模块

3. 注意力机制的可解释性

4. 注意力机制中的稀疏激活

5. 基于注意力机制的预训练模型

6. 适用于注意力机制的优化方法

7. 部署注意力机制的模型

参考文献

//

本文来自:公众号【图形学与几何计算】

作者:ggc

Illustrastion by Icons8

本周上新!

扫码观看!

12.02(周四)

12.07(周二)

12.08(周三)

Talk366期 算法工程师孙泽维

12.09(周四)

MMAI系列Talk③莫纳什大学在读博士琚烈

12.12(周日)

12.16(周四)

MMAI系列Talk④莫纳什在读博士戈宗元

关于我“门”

▼